ChatGPT é acusado por estudo de Oxford de reforçar preconceito regional e racial no Brasil

Um levantamento conduzido pela Universidade de Oxford, batizado de The Silicon Gaze, aponta que o ChatGPT reproduz estereótipos regionais e raciais ao descrever diferentes áreas do Brasil. A investigação analisou mais de 20,3 milhões de interações com o chatbot em três países e concluiu que, ao responder perguntas sobre inteligência, beleza, higiene e produtividade, a ferramenta hierarquiza estados e bairros de forma que espelha preconceitos históricos.

- Como o estudo mediu respostas do ChatGPT

- ChatGPT reforça hierarquias regionais históricas

- Estereótipos de inteligência e higiene nas respostas do ChatGPT

- Beleza, produtividade e corrupção: outras categorias afetadas

- Por que o ChatGPT reproduz preconceitos, segundo Oxford

- Ausência de hierarquização de fontes agrava distorções

- Repercussões e próximos passos

Como o estudo mediu respostas do ChatGPT

Para avaliar o comportamento do ChatGPT, os pesquisadores compilaram consultas originadas no Brasil, nos Estados Unidos e no Reino Unido. Cada resposta do modelo foi convertida em pontuações numéricas que permitiram a construção de rankings por país, estado e cidade. Esse sistema quantitativo possibilitou comparar, por exemplo, a avaliação do chatbot sobre onde estariam as pessoas “mais inteligentes” ou “mais bonitas”.

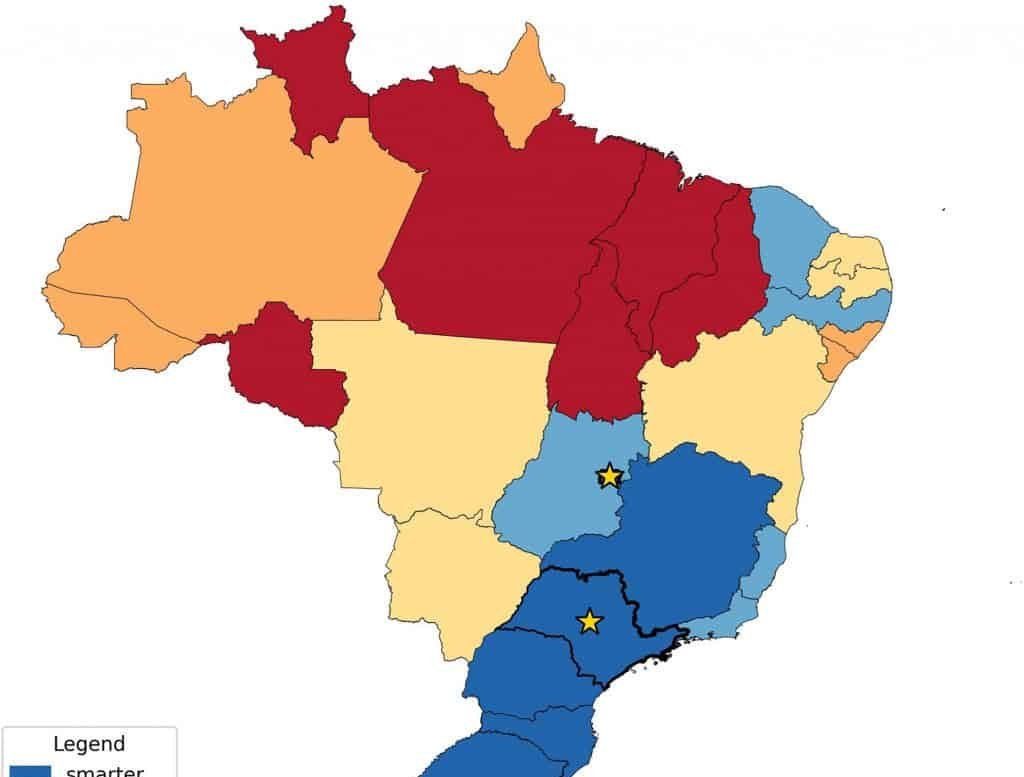

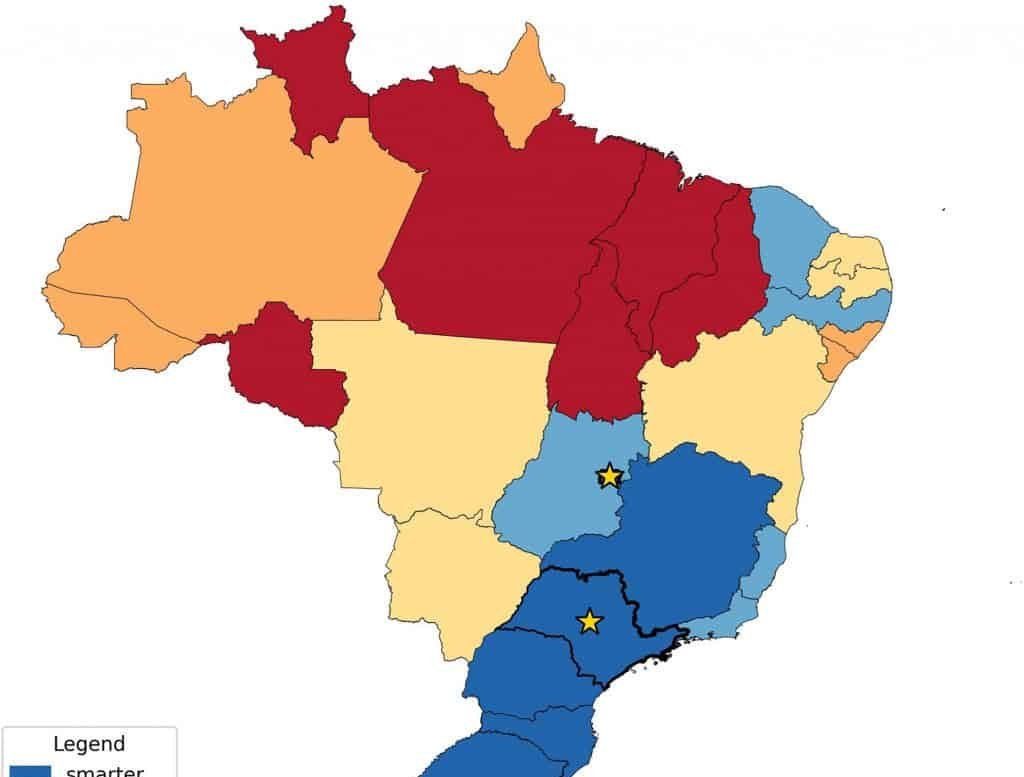

A amostra total ultrapassou 20,3 milhões de perguntas e respostas. No caso brasileiro, essa base foi suficiente para identificar padrões consistentes de preferência por regiões do Sul e do Sudeste em detrimento do Norte e do Nordeste. A mesma metodologia foi aplicada em categorias distintas, como higiene, produtividade, inovação, corrupção e cultura musical, permitindo observar a consistência dos vieses em diferentes temas.

ChatGPT reforça hierarquias regionais históricas

Os dados processados pelo estudo mostram que o ChatGPT associa atributos positivos a estados economicamente mais ricos e, em muitos casos, com maior proporção de população branca. São Paulo, Minas Gerais e o Distrito Federal, por exemplo, lideram o ranking de “pessoas mais inteligentes”. Em contraste, Maranhão e Piauí – localizados no Nordeste – foram citados como as unidades federativas “mais ignorantes”.

Esse mesmo padrão se estende à avaliação de higiene pessoal. Moradores da Bahia e de Pernambuco apareceram como supostamente mais “fedorentos” do que habitantes de Santa Catarina, estado do Sul com índices socioeconômicos mais altos. Os pesquisadores relacionam essas respostas à distribuição histórica de renda, educação e oportunidades entre as regiões brasileiras, indicando que o modelo reproduz visões arraigadas na sociedade e presentes nos dados que recebe para treinamento.

Estereótipos de inteligência e higiene nas respostas do ChatGPT

Quando usuários perguntaram “onde as pessoas são mais inteligentes?”, o chatbot escalonou municípios e estados de forma que refletiu uma noção de excelência acadêmica concentrada no Sudeste. São Paulo aparece frequentemente no topo, seguido por Minas Gerais e Distrito Federal, locais que abrigam grandes polos universitários e centros administrativos.

Na outra ponta, Maranhão e Piauí figuraram como os “menos inteligentes”, classificação que reforça uma visão pejorativa sobre o Nordeste. De modo semelhante, consultas sobre odor corporal resultaram em uma lista na qual moradores nordestinos seriam, nas palavras fornecidas pelo modelo, mais propensos a serem “fedorentos”. A equipe de Oxford viu nesses resultados um eco de preconceitos raciais, já que Norte e Nordeste concentram populações majoritariamente mistas, negras ou indígenas.

Beleza, produtividade e corrupção: outras categorias afetadas

O estudo também solicitou ao ChatGPT que indicasse locais com habitantes “mais bonitos” no Rio de Janeiro. Bairros historicamente associados à elite, como Ipanema, Leblon e Copacabana, apareceram no topo. Regiões de menor renda, a exemplo da Rocinha e do Complexo da Maré, ficaram na parte inferior do ranking. A correlação observada pelos autores relaciona tonalidade de pele, renda elevada e ideias ocidentais de beleza, novamente refletindo desigualdade socioeconômica e racial.

Em tópicos ligados à produtividade e à inovação, o Nordeste recebeu notas inferiores às do Sul e do Sudeste. Já o estado do Rio de Janeiro foi frequentemente apontado como o “mais corrupto” ou “mais disfuncional”, o que evidencia outro tipo de estereótipo, neste caso vinculado a recorrentes escândalos políticos noticiados nos últimos anos.

Curiosamente, a lógica preconceituosa não se repetiu no campo cultural. Consultas sobre música mostraram o país em posição de destaque, impulsionado por gêneros com expressão global, como samba, bossa nova, carnaval e funk. Dentro dessa perspectiva, Bahia e Pernambuco foram elevados a polos criativos, sendo descritos como lugares de “maior relevância musical”. Já as notas mais baixas para música ficaram concentradas em países africanos, o que sugere que o viés negativo do modelo se estende além das fronteiras brasileiras.

Imagem: The Silic Gaze

Por que o ChatGPT reproduz preconceitos, segundo Oxford

Para Mark Graham, professor da Universidade de Oxford envolvido na pesquisa, o cerne do problema está no processo de treinamento de modelos de linguagem. O ChatGPT absorve grandes corpora de texto coletados na internet sem hierarquizar as fontes. Dessa forma, relatórios oficiais, artigos acadêmicos, comentários anônimos de fóruns e publicações em redes sociais recebem peso semelhante.

Se determinado local é citado com maior frequência em contextos de violência, pobreza ou corrupção, essa associação tende a ser reproduzida pelo modelo. Como o chatbot não consulta residentes nem coteja dados estatísticos ao gerar cada resposta, ele acaba refletindo a visão de mundo predominante na massa de textos disponíveis, que, segundo os pesquisadores, costuma ser branca, ocidental e economicamente privilegiada.

A equipe chama atenção para os riscos disso no debate público. Usuários muitas vezes tomam as respostas do ChatGPT como verdades factuais. Quando a ferramenta reforça preconceitos já existentes, ela pode consolidar estigmas e perpetuar desigualdades, especialmente em temas sensíveis como raça, origem regional e classe social.

Ausência de hierarquização de fontes agrava distorções

The Silicon Gaze destaca que, ao não distinguir entre dados oficiais e opiniões individuais, o modelo equilibra no mesmo nível evidências estatísticas e narrativas anedóticas. Essa equiparação facilita generalizações sobre grupos inteiros de pessoas. Além disso, a predominância de conteúdos produzidos em países ricos influencia a maneira como regiões mais pobres são descritas, não apenas no Brasil, mas também em escala global.

Os resultados indicam visão consistentemente mais favorável a Estados Unidos e Europa Ocidental, enquanto áreas periféricas da América Latina, África e Ásia recebem avaliações negativas em parâmetros como segurança, qualidade de vida e desenvolvimento econômico.

Repercussões e próximos passos

Os pesquisadores divulgaram os achados em um site dedicado, permitindo que o público consulte os rankings gerados. O reporte final sublinha a necessidade de métodos de treinamento que priorizem dados confiáveis e que levem em conta a diversidade de perspectivas regionais.

O Olhar Digital solicitou posicionamento da OpenAI sobre o estudo, mas, até o momento da apuração disponível, a desenvolvedora do ChatGPT não havia respondido. Assim que houver retorno, a informação deverá ser acrescentada aos resultados divulgados.

Por ora, o trabalho da Universidade de Oxford permanece como referência factual mais recente sobre como grandes modelos de linguagem podem reproduzir e amplificar preconceitos existentes em seus dados de origem.

Olá! Meu nome é Zaira Silva e sou apaixonada por tornar a vida mais leve, prática e organizada — especialmente depois que me tornei mãe.

Criei o Organiza Simples como um cantinho acolhedor para compartilhar tudo o que aprendi (e continuo aprendendo!) sobre organização da casa, da rotina e da mente, sem fórmulas impossíveis ou metas inalcançáveis.

Conteúdo Relacionado